L’automne dernier, j’ai assisté à une conférence de Yann Le Cun, l’ancien chef de division de recherche en intelligence artificielle (IA) chez Facebook, dans le cadre d’un événement des Integrated Management Symposiums, chapeauté par la Faculté de gestion Desautels. Celui-ci cherchait à communiquer une perception juste des applications de l’IA à un parterre varié issu du domaine académique, des affaires et des syndicats.

Son approche pour l’évènement fut intéressante ; plutôt que de parler directement des applications en IA, il a d’abord tenté de fournir une approche globale de son fonctionnement, un canevas permettant à l’audience d’effectuer sa propre analyse et de participer au débat. Lors de discussions sur l’IA, le fonctionnement est souvent mis à l’arrière-plan pour faire place uniquement aux résultats des applications. Or le fonctionnement devrait être la base de la structure du débat. Dans cet article, le potentiel technique de l’IA ne sera pas mis de l’avant, il sera plutôt question des considérations morales en IA.

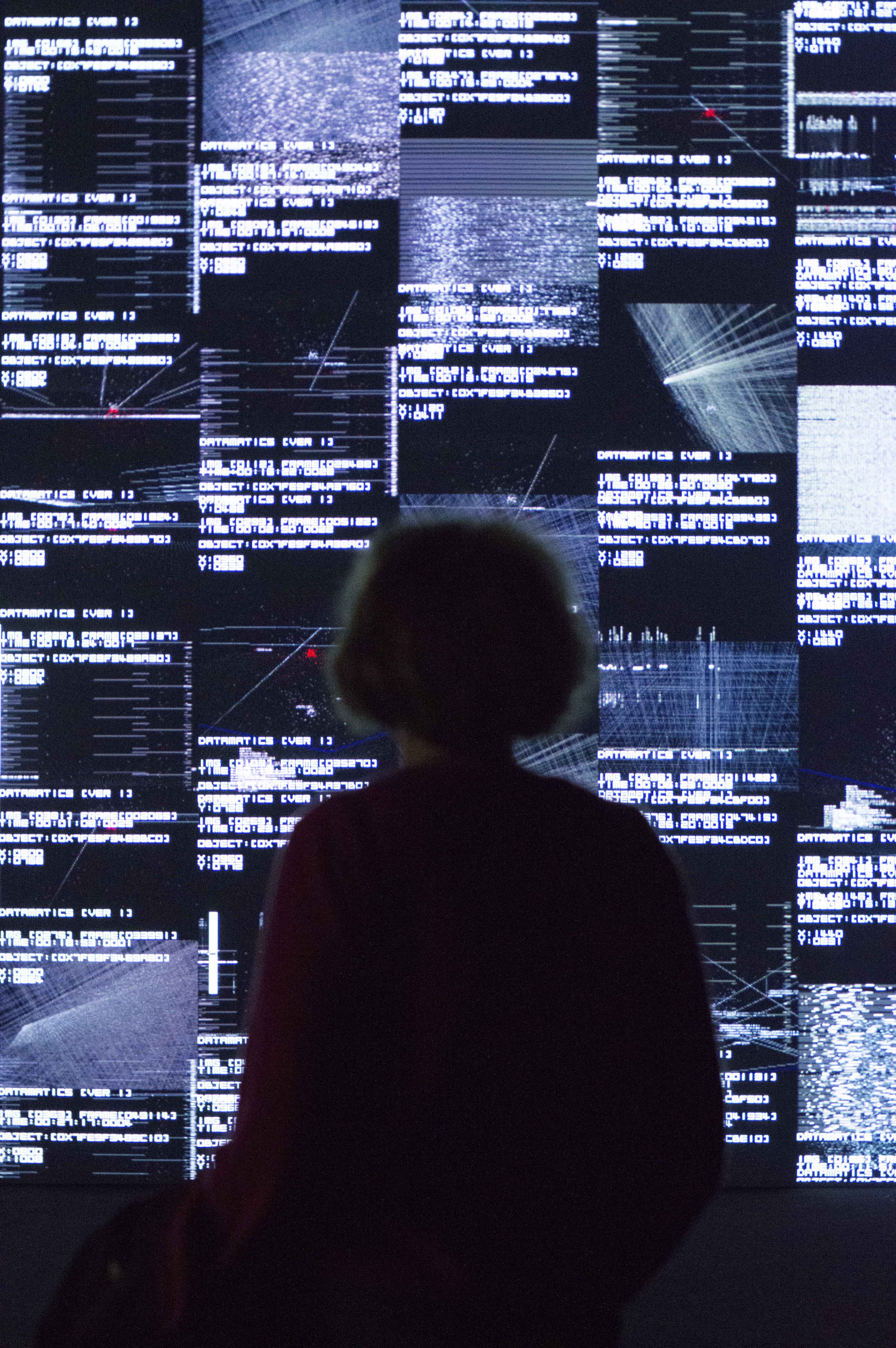

L’intelligence artificielle est de plus en plus présente dans nos vies. Elle numérise nos chèques lors de dépôts bancaires, embellit les photos de nos téléphones intelligents, conduira bientôt nos voitures et est de plus en plus utilisée en industrie.

L’IA et l’apprentissage profond

Comment peindre un tableau éclairant du fonctionnement de l’IA ? L’intelligence artificielle est une branche de l’informatique qui cherche à produire des machines capables d’interagir intelligemment, de façon analogue ou supérieure à l’être humain. Plusieurs pistes ont été explorées dans les dernières décennies pour y arriver. Nous avons tenté de programmer des systèmes experts reproduisant le cheminement cognitif d’un être humain à la manière d’un arbre de décisions, or il se trouve que le raisonnement humain est complexe et non linéaire. C’est donc pour pallier à ce déficit que les systèmes d’apprentissage profond ont été développés, ceux-ci permettent à l’ordinateur d’extrapoler des conclusions dans un domaine bien spécifique en fonction de données. Par exemple, on fournit un grand échantillon de photos de chiffres à un ordinateur avec leur interprétation ; « cette photo représente un ‘‘deux’’ ». Avec suffisamment de données, un ordinateur peut ainsi « apprendre » à identifier l’image du chiffre « cinq » et à la différencier de celle d’un « quatre ». Bref, dans un environnement approprié, un ordinateur peut apprendre à faire des déductions spécifiques grâce à l’information contenue dans un échantillon de données. Les applications de l’IA prennent habituellement la forme de tâches pouvant être réalisées rapidement par un humain, comme reconnaitre un objet sur une photo, un mot dans un enregistrement ou traduire adéquatement une phrase.

Les préoccupations éthiques

En ce sens, il est possible de subdiviser les préoccupations éthiques en intelligence artificielle en trois catégories. Premièrement, on peut se demander d’où proviennent les données utilisées pour permettre au logiciel d’apprendre, et si leur utilisation respecte le consentement de l’individu fournissant les données. La deuxième application est la plus évidente, il ne faut pas utiliser l’IA à des fins immorales. Et finalement, la troisième et probablement la plus intéressante : les données utilisées permettent-elles d’arriver à un résultat moral ? Il se trouve que les comportements immoraux de notre société apparaissent lors d’analyses statistiques, il faut donc éviter qu’un système d’IA tire des conclusions à partir de données biaisées.

Il se trouve que les comportements immoraux de notre société apparaissent lors d’analyses statistiques, il faut donc éviter qu’un système d’IA tire des conclusions à partir de données biaisées.

L’impact des biais

Commençons par le dernier cas, soit les sources de biais dans les données. En effet, les systèmes d’intelligence artificielle ne sont que le produit des données qui en sont les intrants. En ce sens, ils peuvent être victimes de biais raciaux, sexistes ou idéologiques. Il est donc crucial de repérer ces biais pour éviter que l’intelligence artificielle ne soit une source de discrimination. Un exemple serait le traitement de prêts bancaires de façon automatique à l’aide de systèmes d’intelligence artificielle. En mars 2018, un article du New York Times mettait en lumière le fait qu’aux États-Unis, les gens de minorités visibles, particulièrement les Afro-Américains et Américains d’origine hispanique ont plus de chance de se faire refuser un prêt hypothécaire, et ce, pour un revenu et une hypothèque équivalents. Ainsi, il faut être prudent avec l’intelligence artificielle pour éviter ce type de biais, cela est capital pour maintenir la confiance du public envers cette nouvelle technologie. Pallier à ces travers est d’ailleurs un domaine de recherche effervescent en intelligence artificielle, soit la correction des biais humains en IA.

Une utilisation éthique des données

Deuxièmement, il faut aussi considérer la source des données utilisées. À l’ère de l’économie digitale, nos données sont souvent collectées suite à une demande de consentement en petits caractères à la fin d’un formulaire automatisé. Il est donc essentiel que ces données ne soient pas utilisées au détriment des gens les fournissant, à des fins discriminatoires, ou pour cibler et influencer des groupes vulnérables comme des personnes mineures, à faible revenu ou susceptibles d’être influencés par la désinformation. Les données sont des outils très puissants, comme ont pu en témoigner les dernières élections américaines, bien que l’intelligence artificielle n’ait pas été en cause. L’IA pourrait cependant être un catalyseur dangereux dans ce type de situations. Il y a ainsi place à l’amélioration pour que les données digitales des utilisateurs soient collectées avec un consentement probant et ne soient pas utilisées à des fins discriminatoires. En ce sens, les acteurs gouvernementaux et du milieu des affaires devront être plus impliqués.

Une utilisation à des fins morales

Avant de conclure, abordons le sujet recevant la plus grande attention médiatique, soit la prévention de l’utilisation de l’intelligence artificielle comme une arme de guerre ou à des fins dangereuses. En effet, il est vrai que l’intelligence artificielle est potentiellement dangereuse, elle peut être utilisée pour porter atteinte à la vie d’autrui. Si ce type d’application doit être interdit par les entités gouvernementales appropriées pour éviter que la vie d’un humain ne soit mise entre les mains d’un algorithme, il est cependant plus complexe de déterminer si un système d’IA peut être en situation de décision quand la santé d’un être humain est en danger. Par exemple, dans une voiture automatisée ou lors de l’analyse d’un scan en radiologie, un ordinateur peut-il remplacer un être humain ? Et si l’IA artificielle est en moyenne un conducteur plus sécuritaire, ou pose des diagnostics plus justes qu’un médecin, peut-elle remplacer un humain dans une situation où sa prise de décisions peut causer la mort en cas de mauvais diagnostic ?

L’intelligence artificielle est de plus en plus présente dans nos vies. Elle numérise nos chèques lors de dépôts bancaires, embellit les photos de nos téléphones intelligents, conduira bientôt nos voitures et est de plus en plus utilisée en industrie. Son progrès est indéniable, mais il doit être accompagné des considérations appropriées pour éviter qu’un faux pas ne soit commis. La Montreal AI Ethics Institute se penche d’ailleurs sur ces questions et cherche aussi à assurer une plus grande démocratisation des connaissances de l’intelligence artificielle pour en accentuer l’impact positif dans la société. Il est primordial de faire de l’intelligence artificielle un avancement pour tous, et pas uniquement pour une minorité.

[police2018menu]